发布日期:2024-12-05 20:44 点击次数:161

剪辑:peter东 乔杨26uuu图片

【新智元导读】大模子如今已具有越来越长的险峻文,而与之相伴的是推理资本的高涨。英伟达最新忽视的Star Attention,大概在不弃世精度的同期,权贵减少推理诡计量,从而助力边际诡计。

当下的手机及AIPC中齐会装置腹地大模子,干系词险峻文长度增多,推理时的诡计资本也会权贵增长。最较着的一个后果即是,用户输入问题后需要恭候很久才调看到死心。

为此,已有多种优化决议忽视,举例Flash Attention,而11月26日英伟达忽视的Star Attention机制,可用于进步Transformer模子在贬责长序列时的效果和准确性。

值得一提的是,这篇著述受到了鄙俗的瞻仰,登顶Hugging Face逐日论文榜首。

论文地址:https://arxiv.org/abs/2411.1711626uuu图片

Star Attention何如镌汰推理资本

在了解Star Attention何如翻新大模子推理前,让咱们先望望现时大模子的推理经由波及的两个圭表:

1)prompt编码,即模子贬责输入并在缓存中存储KV(键值)向量;

2)token生成,即模子瞻仰KV缓存并自纪念生成新令牌,同期用新 的KV向量更新缓存。

在好多长险峻文任务中,输入由一个长险峻文后跟一个短查询和一个短谜底构成。当大模子的险峻文变得越来越长之后,回答查询所需的信息经常局限在险峻文的小部天职,意味着险峻文只需瞻仰近邻的token,而查询token需要瞻仰扫数之前险峻文波及的推行。

Star Attention下的两阶段推理

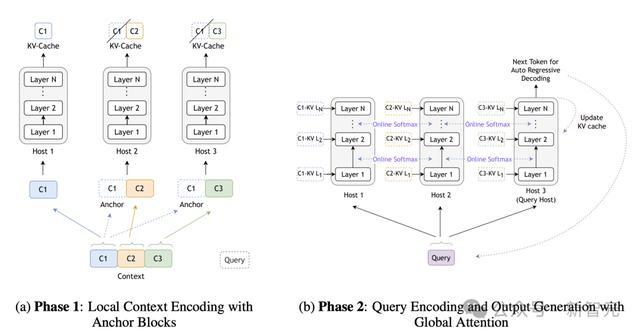

系统中扫数拓荒被分组为多个主机(host),其中一个主机被记号 为「查询」主机。输入序列分为两个阶段贬责。

阶段一:险峻文编码

输入的险峻文部分被分割成较小的块,并分拨到各个主机。除了第一个块除外,扫数块的前边齐加上一个开动块,称为「锚点」块(anchor block)。每个主机贬责其分拨的块,并存储非锚点部分的KV缓存。

快播黄片阶段二:查询编码和token生成

输入查询被播送到扫数主机,在每个主机中,它领先看望在第一阶段诡计出的腹地KV缓存。然后「查询」主机通过团员扫数主机的softmax归一化统计数据来诡计全局小心力。这个经由关于每个生成的token齐会重叠。

用一个不那么严谨的例子来玄虚上头的经由:念念象一场烹调比赛(险峻文token),每个厨师(主机)厚爱准备沿途菜的一部分(块)。

为了确保滋味一致,每个厨师除了准备我方的部分,还在前边加了极少「锚点」调料(锚点块)。每个厨师准备好我方的部分后,记取我方部分的口味(KV缓存)。

阶段二的查询编码和token生成可视为:评委(查询token)来回味菜肴,并决定下沿途菜的口味(生成新token)。评委先回味每个厨师的部分,望望哪个部分最合乎他们的口味。

临了,评委汇总扫数厨师的倡导,笃定下沿途菜的口味,并告诉厨师们。

Star Attention的性能进步

Star Attention带来的性能进步,主要体当今以下两个方面:

1)高达11倍的加快

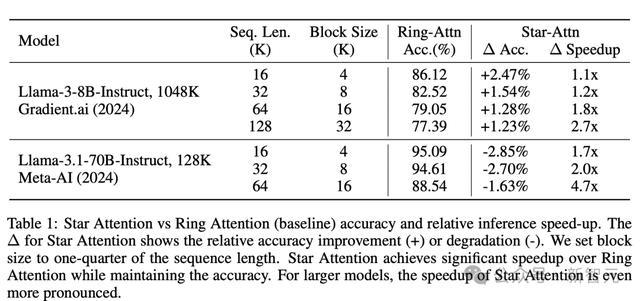

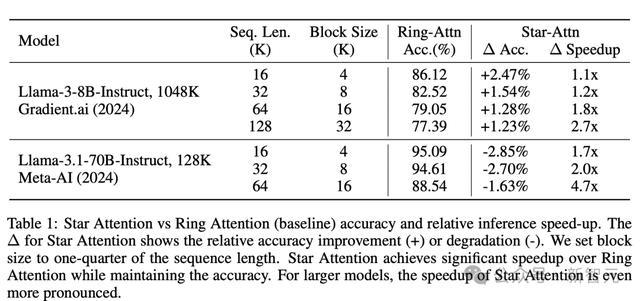

在多个长险峻文基准测试上,Star Attention所加抓的8B Llama3的推理速率权贵进步,跟着序列长度增多,加快比从1.1x进步到2.7x。

而在参数目更大的Llama3.1-70B上,推理的加快比进步更为权贵。

与此同期,对比聘用全局小心力的基准,Star Attention相瞄准确率的镌汰只在0~3%畛域内。

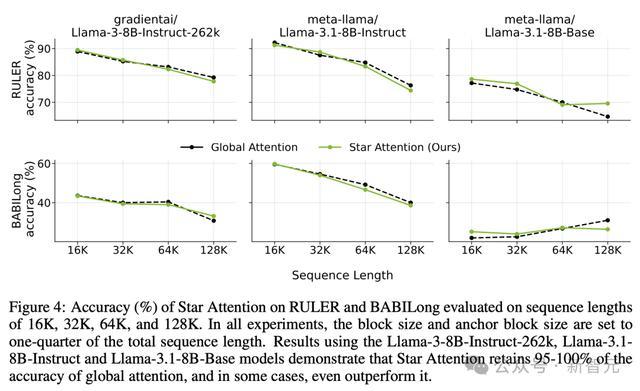

跟着险峻文长度的增多,star attention推理的准确性比较全局小心力险些换取,但推理诡计资本权贵下落

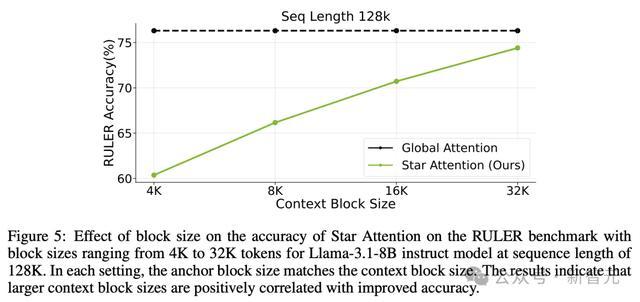

在更长的险峻文模范(128K)中,险峻文编码经由中不同块的大小,也会影响推理的准确性和速率。块尺寸越大,Star Attention 的准确性越高。

在 RULER 基准测试上,不同块大小对Star Attention准确性的影响,块大小畛域从4K到32K,适用于序列长度为128K的Llama-3.1-8B instruct 模子

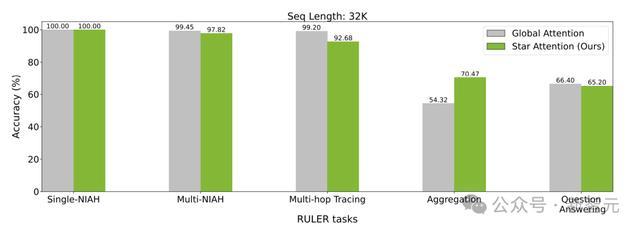

用于评估的RULER,包含了13个任务,分为4个规模:大海捞针 (检索)、多跳跟踪、团员和问答,

不同任务中,全局小心力和Star Attention的准确性互异对比

而在险峻文长度更大,达到1048K时,Star Attention的推理准确性依旧保抓在原基准90%,推理加快比达到了10.8×~16.9×。

而在更大的Llama3.1-70B中,Star Attention能已毕更大的加快比,同期保抓一样水平的准确率下落。

由于其运行机制不波及具体模子,Star Attention不错无缝集成到大多半通过全局小心力历练的基于Transformer的LLMs中,无需特等的模子微调。

由于减少了推理的诡计资本,Star Attention权贵减少了内存需求,使得在腹地拓荒(如手机,札记本中)用LLM贬责更长的序列成为可能。

实验发现,将块大小熏陶为总序列长度的约四分之一,不错在精度和速率之间得回最好均衡。而用户也不错凭证需求颐养块大小,以在诡计效果和精度之间进行量度。

论断

往常的征询,会尝试将Star Attention推广到更长的序列(最长可达1M)和更大的模子,并但愿能不雅察到甚而更的加快,同期保抓一样水平的准确率。同期专注于优化「锚块」机制,并在更复杂的长险峻文任务上提高性能,以增强Star Attention的可推广性和庄重性。

总的来看,关于念念要开发部署腹地大模子的厂商,Star Attention是一项阻截错过的时期。使用Star Attention后,腹地LLM大概更快地回期骗户,还可在有限的内存中兼容更长的险峻文序列,从而在RAG任务中阅读更长的文本。

而关于云霄大模子的提供商,Star Attention大概在险些不影响用户体现的前提下,权贵进步推理资本,已毕「降本增效」,同期减少动力破费(碳脚迹)。

通过在多个主机间分拨险峻文贬责,Star Attention使险峻文长度大概随主机数目线性推广。

参考辛苦:

https://arxiv.org/abs/2411.17116